Le Règlement européen sur l’intelligence artificielle (plus couramment désigné sous le nom d’« AI Act ») a été adopté le 13 juin 2024. Ce texte constitue la première régulation mondiale encadrant les technologies d’intelligence artificielle. Il sera complété par une directive relative à la responsabilité en matière d’IA.

Le règlement repose sur le constat que l’intelligence artificielle fait partie d’une famille de technologies en évolution rapide, offrant de nombreux avantages, mais présentant également des risques pour les individus, qu’ils soient physiques, psychologiques, sociétaux ou économiques (considérants 3 et 4).

L’AI Act s’adresse principalement aux fournisseurs et développeurs d’intelligence artificielle, c’est-à-dire aux entreprises qui conçoivent et commercialisent des produits et services intégrant des composantes d’IA. Il concerne aussi les utilisateurs professionnels d’IA, imposant certaines obligations lorsque l’IA est utilisée à titre professionnel. Conçu pour rester pertinent malgré l’évolution des technologies, il vise à encadrer les innovations futures dans ce domaine.

Ses objectifs principaux (art. 1) sont d’améliorer le fonctionnement du marché intérieur en favorisant le développement d’une intelligence artificielle fiable et centrée sur l’humain, tout en assurant un niveau élevé de protection de la santé, de la sécurité, des droits fondamentaux, de la démocratie, de l’État de droit et de l’environnement face aux risques potentiels des systèmes d’IA.

L’AI Act instaure un cadre juridique basé sur les cas d’usage, c’est-à-dire qu’il prend en compte les fonctions et finalités spécifiques de chaque système d’IA. Ainsi, une entreprise utilisant plusieurs systèmes d’intelligence artificielle pour des objectifs différents devra s’assurer de la conformité individuelle de chacun d’eux.

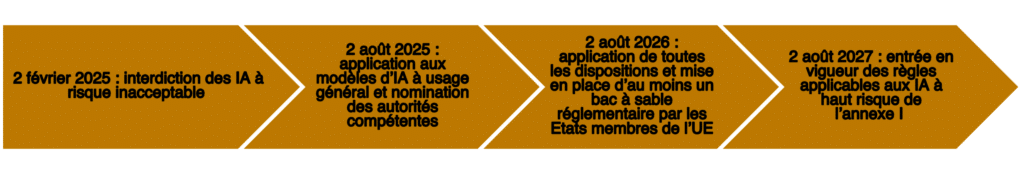

Le règlement a été publié au Journal officiel de l’Union européenne le 12 juillet 2024, et est entré en vigueur le 2 août 2024. Son application se fera progressivement selon le calendrier suivant :

L’AI Act définit les systèmes d’intelligence artificielle (SIA) comme des systèmes basés sur des machines capables de fonctionner de manière autonome, d’apprendre et de s’adapter après leur déploiement. Leur but est de produire des résultats tels que des prédictions, des recommandations ou des décisions, influençant des environnements physiques ou virtuels (art. 3, 1). L’intelligence artificielle englobe un large éventail de techniques imitant des fonctions humaines comme le raisonnement ou l’apprentissage automatique, avec des applications variées, allant des moteurs de recherche aux systèmes décisionnels.

Le règlement s’applique à tous les SIA en fonction de leur usage, et non de leur technologie ou de l’utilisateur. Toutefois, certains systèmes à usage régalien, ainsi que les institutions publiques, sont exclus de son champ d’application. Il s’agit notamment des SIA développés à des fins militaires, ou des systèmes utilisés par des autorités publiques ou organisations internationales dans le cadre d’accords de coopération répressive et judiciaire avec l’UE, sous réserve que ces entités respectent les droits fondamentaux.

Le texte ne s’applique pas non plus aux systèmes développés pour la recherche scientifique, à moins que ceux-ci ne soient commercialisés (art. 2, 6). Il exclut également les questions relevant de la sécurité intérieure des États membres.

L’AI Act vise à encadrer le marché européen des systèmes d’intelligence artificielle (SIA) et s’applique dès qu’un SIA ou ses résultats sont utilisés dans l’UE. Comme le RGPD, l’AI Act est extraterritorial et concerne :

- les fournisseurs, qu’ils soient établis dans l’UE ou dans un pays tiers, qui mettent sur le marché ou en service des systèmes d’IA ou des modèles d’IA à usage général dans l’UE ;

- les utilisateurs professionnels de SIA situés dans l’UE ;

- les fournisseurs et utilisateurs situés dans des pays tiers, dès lors que les résultats produits par le SIA sont utilisés dans l’UE ;

- les importateurs et distributeurs de systèmes d’IA ;

- les fabricants qui commercialisent un produit intégrant un SIA sous leur propre nom ou marque ;

- les mandataires des fournisseurs non établis dans l’Union ;

- les personnes dont les données personnelles sont traitées dans l’UE.

L’AI Act classe les systèmes d’intelligence artificielle (SIA) en fonction de leur niveau de risque, allant de l’inacceptable au minime. Chaque niveau de risque impose des obligations spécifiques, allant de l’interdiction à des règles de transparence. Le texte prévoit aussi un régime particulier pour les IA génératives.

Il commence par énoncer des usages interdits de l’IA, tels les systèmes d’IA exploitant des techniques subliminales, influençant à l’insu des utilisateurs, ou exploitant la vulnérabilité des individus. Il en va de même pour les systèmes classifiant les personnes selon leur comportement social ou des caractéristiques personnelles. Dans le domaine de la sécurité publique, l’identification biométrique en temps réel est interdite, sauf exception autorisée par une autorité compétente.

Le Règlement envisage ensuite les SIA dits à haut risque. Les systèmes d’IA sont classés comme à haut risque dans deux cas :

- Ils sont déployés en tant que produits ou composants de sécurité soumis aux directives européennes sur la sécurité des produits.

- Ils sont utilisés dans des cas sensibles comme l’identification biométrique, l’accès à des services essentiels (éducation, emploi, crédit, etc.), ou l’aide aux autorités judiciaires. Toutefois, certaines IA, comme celles aidant à des tâches humaines sans influencer directement la décision finale, sont exclues de cette catégorie.

Les fournisseurs de systèmes d’IA à haut risques doivent respecter plusieurs obligations tout au long du cycle de vie du SIA : gestion des risques, gouvernance des données, enregistrement des événements, transparence, contrôle humain, et cybersécurité. Une documentation technique est exigée, et les PME pourront bénéficier de procédures simplifiées.

Les systèmes à faible risque, comme les chatbots ou les deepfakes, ne sont pas soumis aux mêmes contraintes, mais doivent respecter certaines obligations de transparence, comme informer les utilisateurs qu’ils interagissent avec une IA, sauf si cela est évident pour une personne raisonnable.

Viennent ensuite les systèmes d’IA à usage général. Ces IA, comme ChatGPT, sont des modèles polyvalents capables de remplir diverses tâches et peuvent être intégrés dans d’autres systèmes. Certains de ces modèles pourraient être classés comme présentant des risques systémiques en raison de leur capacité d’impact ou de leur puissance de calcul. Les fournisseurs offrant des licences libres et gratuites sont exemptés de certaines obligations.

L’article 53 détaille les obligations des fournisseurs de systèmes d’IA à usage général, parmi lesquels l’on trouve notamment le respect des droits de propriété intellectuelle ou encore la possibilité d’accéder à un résumé des données utilisées pour l’entraînement du modèle d’IA.

L’AI Act met en place de nouvelles autorités au niveau européen et national pour superviser et réguler les systèmes d’intelligence artificielle (SIA).

Au niveau européen, le bureau de l’IA, en cours de création par la Commission européenne, sera chargé de superviser les IA à usage général et de coordonner l’élaboration des normes techniques. Il sera également le point de contact pour les déclarations de conformité des IA à haut risque.

Le bureau de l’IA encouragera l’élaboration de codes de bonnes pratiques pour aider les fournisseurs d’IA à usage général à respecter les obligations de l’AI Act. Ces codes, développés en collaboration avec des acteurs variés (fournisseurs, autorités, société civile), devront être prêts au plus tard le 2 mai 2025.

Chaque pays devra par ailleurs désigner une autorité de notification et une autorité de surveillance du marché. Ces entités auront pour rôle de veiller à l’application de l’AI Act, de superviser les bacs à sable réglementaires, et de prononcer des sanctions. En France, le Conseil d’État a suggéré de confier ces responsabilités à la CNIL, en raison des similarités avec la protection des données personnelles.